Recién salido del avión de París con solo 16 horas de sobra, Offset y Quavo se concentraron en planificar la actuación de tributo perfecta para honrar a su difunto miembro del grupo Migos, Takeoff, en los Premios BET 2023 el fin de semana pasado. “Me aclaró el alma”, compartió Offset en un Instagram Live reciente, donde detalló el proceso de armar la aparición sorpresa en el último minuto.

“Hicimos la actuación de BET, hombre, fue icónico”, dijo. “Mi hermano Qua y yo armamos eso en 16 horas, 15 horas, aterrizamos de París a las 9 p.m. y fuimos directamente a trabajar para descubrir cómo armaríamos este espectáculo. Y lo hacemos porque somos verdaderas estrellas. Hacemos esta música. Somos el grupo más grande que jamás haya tocado el micrófono : RIP, mi hermano Take. Lo hicimos por mi hermano Take”.

Takeoff, cuyo verdadero nombre es Kirsnik Khari Ball, fue asesinado a tiros temprano en la mañana del 1 de noviembre de 2022 en una bolera en Houston. Tenía 28 años. El presunto tirador del rapero, Patrick Clark, fue acusado de asesinato en mayo. A principios de este año, durante el segmento In Memoriam en los Premios Grammy 2023, Quavo realizó un tributo a Takeoff without Offset. La aparición de los premios BET marcó la primera vez que actuaron juntos en el mismo escenario desde la muerte de Takeoff.

Tendencias“Qu y yo nos mantuvimos firmes, de hermano a hermano y agradezco a todos por apoyar [us]. Era una película, era una vibra. Necesitábamos eso para la cultura”, agregó. “Sin embargo, lo hicimos en 16 horas, como verdaderos profesionales. Estuve allí 16 horas, no dormí, encerrado en la visión. Qua y yo nos sentamos, concentrados en las imágenes, concentrados en la posición del escenario, la iluminación, todo, como una unidad. Sabes, cuando juntas las tres cabezas, siempre va a ser cinemático. Siempre va a ser la verdad”.

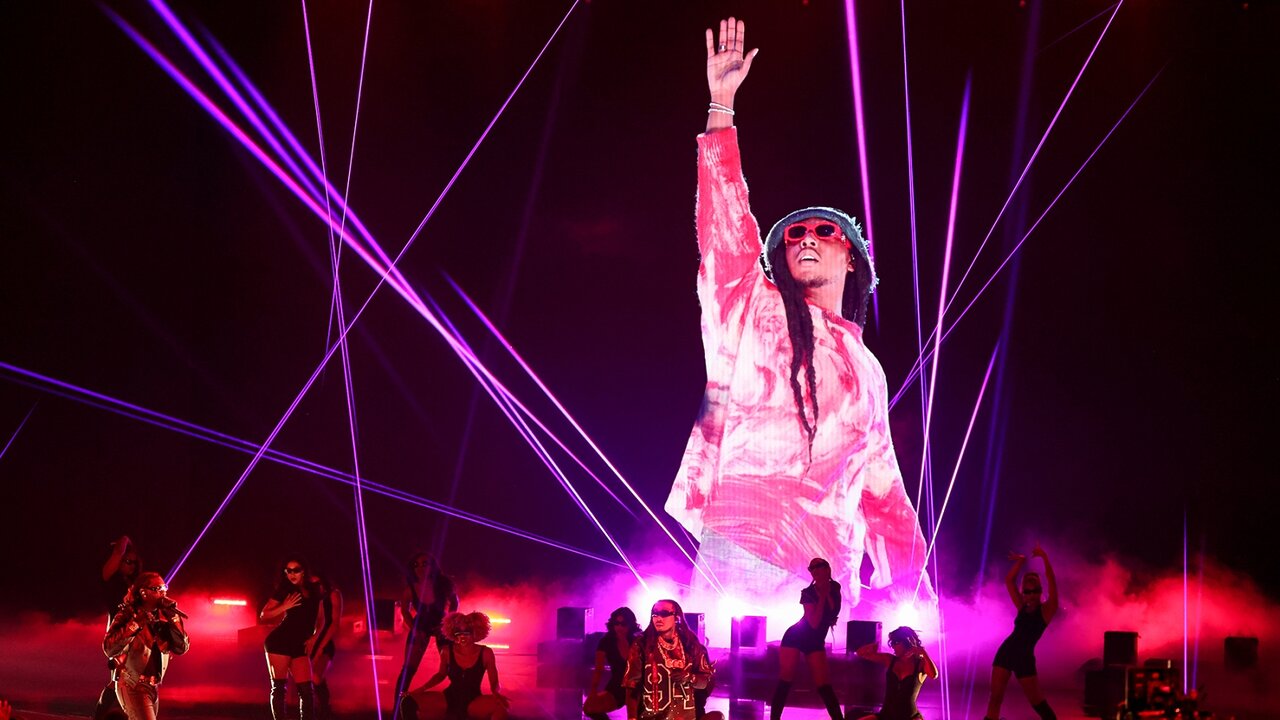

La actuación de la reunión de Offset y Quavo incluyó un popurrí de « Hotel Lobby », que apareció en el álbum colaborativo de Quavo y Takeoff Only Built for Infinity Links bajo el nombre de Unc and Phew, y el exitoso sencillo de Migos « Bad and Boujee ». Mientras los láseres y un fondo de fuego iluminaban el escenario, una imagen de Takeoff extendiendo su mano hacia el cielo se proyectó en la pantalla gigante detrás de ellos.